Nvidia ha lanzado Dynamo, un software de inferencia de código abierto diseñado para acelerar y escalar modelos de razonamiento dentro de las fábricas de IA.

Gestionar y coordinar eficientemente las solicitudes de inferencia de IA en una flota de GPU es un esfuerzo crítico para garantizar que las fábricas de IA puedan operar con una rentabilidad óptima y maximizar la generación de ingresos de token.

A medida que el razonamiento de AI se vuelve cada vez más frecuente, se espera que cada modelo de IA genere decenas de miles de tokens con cada aviso, lo que representa esencialmente su proceso de «pensamiento». Mejorar el rendimiento de la inferencia al tiempo que reduce simultáneamente su costo es, por lo tanto, crucial para acelerar el crecimiento y aumentar las oportunidades de ingresos para los proveedores de servicios.

Una nueva generación de software de inferencia de IA

Nvidia Dynamo, que tiene éxito el servidor de inferencia Nvidia Triton, representa una nueva generación de Inferencia de ai Software diseñado específicamente para maximizar la generación de ingresos del token para fábricas de IA que implementan modelos de IA de razonamiento.

Dynamo orquesta y acelera la comunicación de inferencia en potencialmente miles de GPU. Emplea una porción desglosada, una técnica que separa las fases de procesamiento y generación de modelos de idiomas grandes (LLM) en GPU distintas. Este enfoque permite que cada fase se optimice de forma independiente, atiende a sus necesidades computacionales específicas y garantiza la máxima utilización de los recursos de GPU.

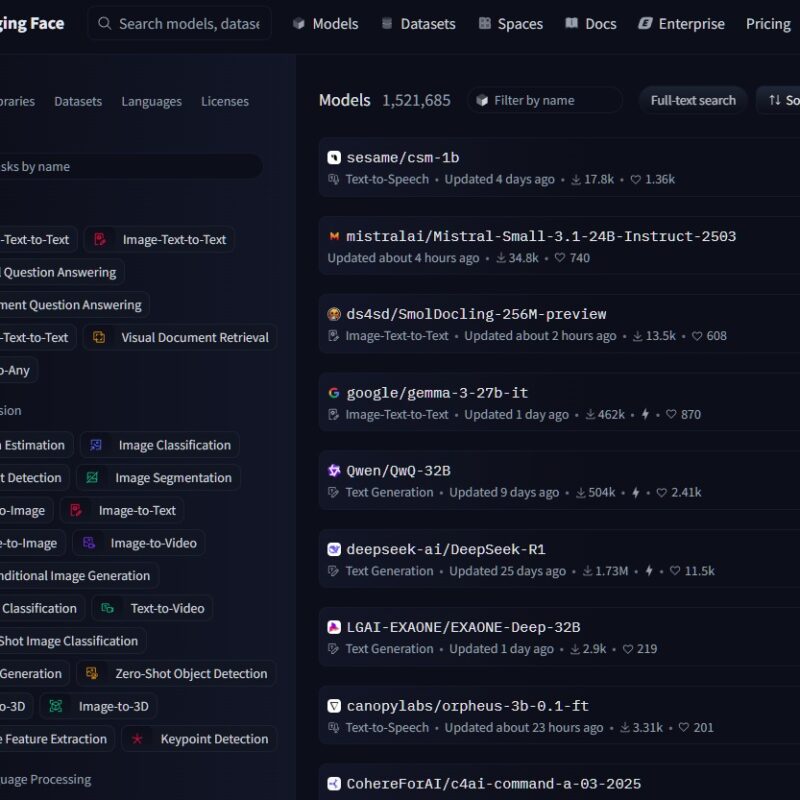

❯ También te interesa: Abrazar la cara requiere un enfoque de código abierto en el plan de acción de AI

Abrazar la cara requiere un enfoque de código abierto en el plan de acción de AI«Las industrias de todo el mundo están capacitando modelos de IA para pensar y aprender de diferentes maneras, haciéndolas más sofisticadas con el tiempo», declaró Jensen Huang, fundador y CEO de Nvidia. «Para habilitar un futuro de razonamiento personalizado, Nvidia Dynamo ayuda a servir a estos modelos a escala, impulsando los ahorros de costos y la eficiencia en las fábricas de IA».

Utilizando el mismo número de GPU, Dynamo ha demostrado la capacidad de duplicar el rendimiento y los ingresos de las fábricas de IA que sirven modelos de LLAMA en la plataforma de tolva actual de NVIDIA. Además, al ejecutar el modelo Deepseek-R1 en un gran grupo de bastidores NVL72 GB200, las optimizaciones de inferencia inteligentes de Nvidia Dynamo han demostrado que aumenta el número de tokens generados por más de 30 veces por GPU.

Para lograr estas mejoras en el rendimiento de la inferencia, Nvidia Dynamo incorpora varias características clave diseñadas para aumentar el rendimiento y reducir los costos operativos.

Dynamo puede agregar, eliminar y reasignar dinámicamente las GPU en tiempo real para adaptarse a los volúmenes y tipos de solicitudes fluctuantes. El software también puede identificar las GPU específicas dentro de los grupos grandes que se adaptan más para minimizar los cálculos de respuesta y enrutar consultas de manera eficiente. Dynamo también puede descargar datos de inferencia a dispositivos de memoria y almacenamiento más rentables al tiempo que lo recupera rápidamente cuando sea necesario, minimizando así los costos generales de inferencia.

Nvidia Dynamo se lanzará como un proyecto de código abierto, que ofrece una amplia compatibilidad con marcos populares como Pytorch, Sglang, Nvidia Tensorrt-LLM y VLLM. Este enfoque abierto apoya empresas, nuevas empresas e investigadores en el desarrollo y optimización de métodos novedosos para servir modelos de IA en infraestructuras de inferencia desglosadas.

❯ También te interesa: EDESCOVERY dado un impulso de AI para la industria farmacéutica

EDESCOVERY dado un impulso de AI para la industria farmacéuticaNvidia espera que Dynamo acelere la adopción de la inferencia de IA en una amplia gama de organizaciones, incluidos los principales proveedores de la nube e innovadores de IA como AWS, Cohere, CoreWeave, Dell, Fireworks, Google Cloud, Lambda, Meta, Microsoft Azure, Nebius, Netapp, Oci, Pergexity, Juntos, AI y VAR.

Nvidia Dynamo: inferencia de sobrealimentación e IA de agente

Una innovación clave de Nvidia Dynamo radica en su capacidad para mapear el conocimiento de que los sistemas de inferencia evitan que la memoria sirviera de solicitudes anteriores, conocidas como el caché KV, potencialmente miles de GPU.

Luego, el software enruta de manera inteligente las nuevas solicitudes de inferencia a las GPU que poseen la mejor coincidencia de conocimiento, evitando efectivamente recomputaciones costosas y liberando otras GPU para manejar nuevas solicitudes entrantes. Este mecanismo de enrutamiento inteligente mejora significativamente la eficiencia y reduce la latencia.

«Para manejar cientos de millones de solicitudes mensualmente, confiamos en las GPU de NVIDIA y el software de inferencia para ofrecer el rendimiento, la confiabilidad y escala que nuestro negocio y los usuarios demandan», dijo Denis Yarats, CTO de IA de perplejidad.

«Esperamos aprovechar a Dynamo, con sus capacidades de servicio distribuidas mejoradas, para impulsar aún más eficiencias de inferencia y satisfacer las demandas de cómputo de los nuevos modelos de razonamiento de IA».

❯ También te interesa: Serie Infinix Note 50: Traer a la IA móvil ‘Gen Beta’ a la vida

Serie Infinix Note 50: Traer a la IA móvil ‘Gen Beta’ a la vidaPlataforma de IA Adherirse ya está planeando aprovechar Nvidia Dynamo para mejorar las capacidades de IA de agente dentro de su serie de comandos de modelos.

«La escala de modelos AI avanzados requiere una sofisticada programación multi-GPU, coordinación perfecta y bibliotecas de comunicación de baja latencia que transfieren los contextos de razonamiento sin problemas a través de la memoria y el almacenamiento», explicó Saurabh Baji, vicepresidente sénior de ingeniería en Cohere.

«Esperamos que Nvidia Dynamo nos ayude a ofrecer una experiencia de usuario principal a nuestros clientes empresariales».

Apoyo para una entrega desglosada

La plataforma de inferencia NVIDIA Dynamo también presenta un soporte robusto para una porción desglosada. Esta técnica avanzada asigna las diferentes fases computacionales de LLM, incluidos los pasos cruciales de comprender la consulta del usuario y luego generar la respuesta más apropiada, a diferentes GPU dentro de la infraestructura.

El servicio desglosado es particularmente adecuado para modelos de razonamiento, como la nueva familia Nemotron Nemotron Family, que emplea técnicas de inferencia avanzadas para una mejor comprensión contextual y generación de respuesta. Al permitir que cada fase se ajuste y se recurre de forma independiente, el servicio desglosado mejora el rendimiento general y ofrece tiempos de respuesta más rápidos a los usuarios.

❯ También te interesa: La legislación de la UE sobre IA genera controversia sobre la transparencia de los datos

La legislación de la UE sobre IA genera controversia sobre la transparencia de los datosJuntos aiun jugador prominente en el espacio de la nube de aceleración de IA, también está buscando integrar su motor de inferencia patentado juntos con Nvidia Dynamo. Esta integración tiene como objetivo permitir una escala perfecta de cargas de trabajo de inferencia en múltiples nodos de GPU. Además, permitirá que AI juntas aborde dinámicamente los cuellos de botella del tráfico que pueden surgir en varias etapas de la tubería del modelo.

«La escala de los modelos de razonamiento de manera rentable requiere nuevas técnicas avanzadas de inferencia, incluida la servicio desglosada y el enrutamiento consciente del contexto», declaró CE Zhang, CTO de Together AI.

«La apertura y la modularidad de Nvidia Dynamo nos permitirán enchufar sin problemas sus componentes a nuestro motor para satisfacer más solicitudes mientras optimizan la utilización de recursos, maximizando nuestra inversión informática acelerada. Estamos entusiasmados de aprovechar las capacidades innovadoras de la plataforma para llevar de manera rentable los modelos de razonamiento de código abierto a nuestros usuarios».

Cuatro innovaciones clave de Nvidia Dynamo

NVIDIA ha destacado cuatro innovaciones clave dentro de Dynamo que contribuyen a reducir la inferencia de costos de servicio y mejorar la experiencia general del usuario:

- Planificador de GPU: Un motor de planificación sofisticado que agrega y elimina dinámicamente las GPU basadas en la demanda fluctuante del usuario. Esto garantiza una asignación óptima de recursos, evitando tanto el sobreprovisionamiento como la subvisión de la capacidad de GPU.

- Router inteligente: Un enrutador inteligente, consciente de LLM que dirige las solicitudes de inferencia en grandes flotas de GPU. Su función principal es minimizar costosas recomputaciones de GPU de solicitudes repetidas o superpuestas, liberando así valiosos recursos de GPU para manejar nuevas solicitudes entrantes de manera más eficiente.

- Biblioteca de comunicación de baja latencia: Una biblioteca optimizada por inferencia diseñada para apoyar la comunicación de GPU a GPU de última generación. Abraza las complejidades del intercambio de datos a través de dispositivos heterogéneos, acelerando significativamente las velocidades de transferencia de datos.

- Administrador de memoria: Un motor inteligente que administra la descarga y la recarga de datos de inferencia hacia y desde los dispositivos de memoria y almacenamiento de menor costo. Este proceso está diseñado para ser perfecto, asegurando que no hay impacto negativo en la experiencia del usuario.

Nvidia Dynamo estará disponible dentro de los microservicios NIM y será compatible con una versión futura de la plataforma de software AI Enterprise de la compañía.

❯ También te interesa: Integrando un chatbot de WhatsApp en tu sitio web con WordPress

Integrando un chatbot de WhatsApp en tu sitio web con WordPressVer también: LG Exaone Deep es un aficionado a las matemáticas, ciencias y codificación

¿Quiere obtener más información sobre AI y Big Data de los líderes de la industria? Verificar AI y Big Data Expo que tiene lugar en Amsterdam, California y Londres. El evento integral está ubicado en otros eventos líderes, incluidos Conferencia de automatización inteligente, Bloqueo, Semana de transformación digitaly Cyber Security & Cloud Expo.

Explore otros próximos eventos y seminarios web tecnológicos empresariales con TechForge aquí.

Fuente: Escalar la inferencia de IA con eficiencia de código abierto

Gitex Global en Asia: el espectáculo tecnológico más grande del mundo

Gitex Global en Asia: el espectáculo tecnológico más grande del mundo